Gondolkodás illúziója

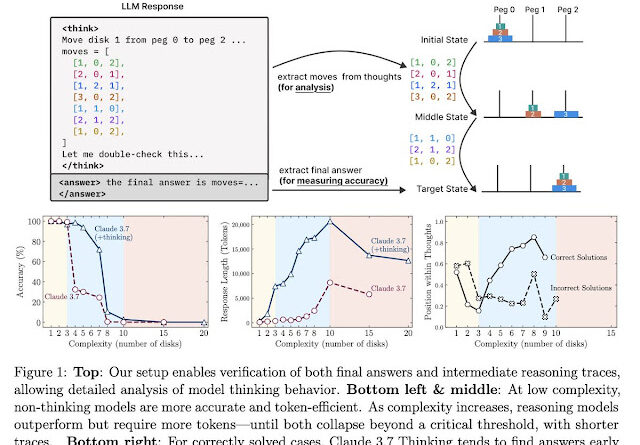

Apple kutatásában elismeri, hogy az érvelő gondolkodásra épülő mesterséges intelligencia modellek – például az o3‑mini, DeepSeek‑R1 és Claude – nem képesek valódi következtetést levonni. A vállalat felmérése szerint ezek a rendszerek jól teljesítenek alacsony vagy közepesen összetett feladatokon, ám magasabb komplexitás esetén teljesen megbízhatatlanná válnak, hibás válaszokat adnak, sőt előfordul, hogy 0 % pontosságot érnek el – még akkor is, ha rengeteg számítási erő áll a rendelkezésükre, például több ezer GPU‑t használó környezetekben is.

Apple szerint a komplex, magas szintű problémákra épülő (reasoning) feladatok igazi megoldása csupán illúzió. A dokumentum szerint a nagy modellek nem képesek a mély következtetési struktúrák kialakítására, még ha a fejlesztők erre építenek is. Ez az eredmény rámutat arra, mennyi önkritikával érdemes kezelni az AI-képességek kommunikációját.

Kiberbiztonsági szempontból ez a felismerés azért fontos, mert a mesterséges intelligencia technológiája – amelyet egyre gyakrabban alkalmaznak védelemre és támadásra is – korlátozottan megbízható akkor, amikor komplex döntéshozatalra van szükség. Tehát az AI-alapú rendszerekbe vetett bizalom nem helyettesítheti a humán szakértői ellenőrzést, különösen olyan helyzetekben, ahol precizitás, megfelelés vagy analitikai mélység szükséges.