Malware elemzés LLM-el

A Cisco Talos részletesen ismerteti, hogyan lehet a nagy nyelvi modelleket — például ChatGPT‑szerű AI‑kat — hatékony segítségként használni malware elemzés során. A cél nem az, hogy a szakértőket felváltsák, hanem hogy automatizálják a rutinfeladatokat, növeljék a hatékonyságot, és lehetővé tegyék a gyorsabb, pontosabb visszafejtést.

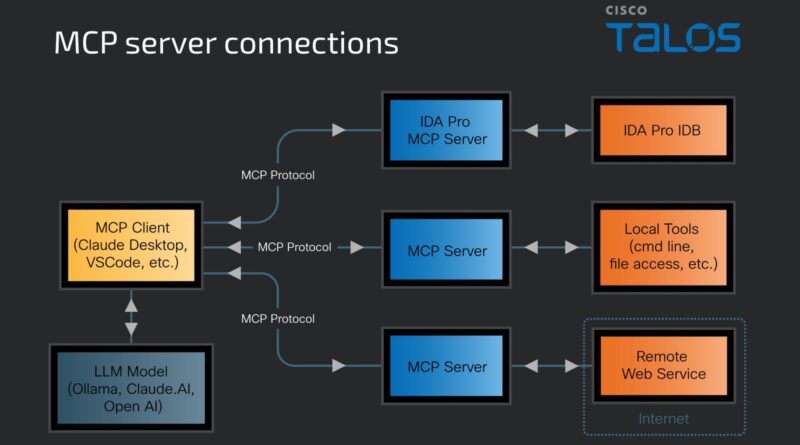

A módszer központi eleme az úgynevezett Model Context Protocol (MCP) használata, amely egy nyílt protokoll arra, hogy egy LLM hozzáférhessen a disassembler vagy decompiler eszközök (például IDA Pro vagy Ghidra) kontextusához. Egy MCP kliens, például VSCode-on keresztül, csatlakozik egy MCP szerverhez, ami biztosítja az API-hívásokat és a kódrészleteket, amelyeket a modell elemezhet.

A felhasználó egyszerű természetes nyelvű utasításokat ad meg az LLM ezt automatikusan Python-szkriptté alakítja, amely IDA Pro API‑val és LLM‑operátorokkal dolgozik. Így létrejönnek olyan automatizált elemzési munkafolyamatok, amelyek gyorsabban felismerik a kódban található mintázatokat, eljárásokat vagy exploit lehetőségeket.

A Talos példában olyan felépítést mutat be, ahol a vizsgálat során a felhasználó annak alapján kér dezódolást, hogy mely függvények AES-t használnak, milyen típusú változókat, hívásláncokat tartalmaznak, és mi a hívási struktúra. Az LLM elmagyarázza az API-hívásokat, dokumentálja a kódot, átnevezi a függvényeket, és javaslatokat ad a vizsgálat folytatásához.

A megközelítés előnye, hogy az elemző képességei kibővülnek, nem kell manuálisan keresni dokumentációt, de az emberi felügyelet továbbra is jelen van, így a szakértő döntheti el, milyen utasítást adjunk tovább és mely részeket ellenőrizzük alaposabban.

A blog kitér az LLM‑választás szempontjaira, szükséges a nagy input-context képesség, strukturált prompt támogatása és lehetőség helyi modellek futtatására (például Ollama vagy vLLM). A Talos bemutatja, hogyan lehet lokálisan GPU‑n futtatott LLM‑et MCP‑vel összekapcsolni, hogy https:// ollama-alapú helyi modell dolgozzon együtt az IDA‑Pro eszközzel, biztosítva ezzel adatbiztonságot és gyors választ.

A költségper‑token alapú API‑hívások drágák lehetnek, az LLM-ek nem mindig értik a kontextust megfelelően, és különösen komplex kódrészek esetén még hibázhatnak. Ezért a javasolt módszer mindig ember és AI párban való használata – ahol az AI segít, de az elemzés irányítását a biztonsági szakértő adja.

A Talos szerint a mai LLM‑alapú eszközök képesek megkönnyíteni a reverse engineering feladatokat, a strukturált információ‑analízist, automatizált szkriptgenerálást és gyorsabb kódfelfedezés révén – de csak akkor működhet jól, ha az ember nem hagyományos promptok helyett valódi szakértői döntésekkel vezeti az AI‑t, és felügyeli a folyamatokat.