K2 Think AI jailbrake a saját funkciójával

Az Egyesült Arab Emírségek Mohamed bin Zayed Mesterséges Intelligencia Egyeteme (MBZUAI) és a G42 együttműködésében nemrégiben kiadott legújabb reasoning modell advanced reasoning rendszerében kritikus sérülékenységet azonosítottak, amelynek következtében a modell belső gondolkodási folyamata véletlenül rendszer szintű utasításokat tesz közzé, lehetővé téve a támadási kísérletek iteratív finomítását.

Az Adversa cikke dokumentálja, hogyan lehet a sikertelen jailbreak-kísérleteket érvelési naplóelemzéssel fegyverként felhasználni a biztonsági intézkedések fokozatos megkerülésére, valamint a fejlett AI Red Teaming fontosságát.

A mesterséges intelligencia átláthatósága számos nemzetközi szabályozás és irányelv által sürgetett, ha nem is kifejezetten előírt tulajdonság. Az EU AI Act például konkrét átláthatósági követelményeket támaszt, beleértve a magyarázhatóságot is – a felhasználóknak képesnek kell lenniük megérteni, hogy a modell hogyan jutott el a következtetéséhez. A cél a felhasználók védelme, az elfogultság megelőzése és az elszámoltathatóság biztosítása – vagyis az AI reasoning hagyományos „fekete doboz” jellegének ellenőrizhetővé tétele. Az Adversa a K2 Think átláthatóságát és magyarázhatóságát kihasználva feltörte a modellt.

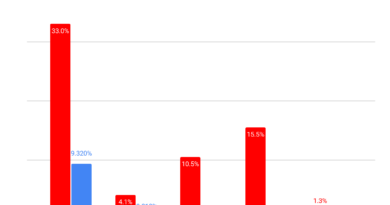

A folyamat koncepciójában rendkívül egyszerű. Egy rosszindulatú kérést kell feltenni a rendszernek, amelyről feltételezhető vagy szinte biztos, hogy el lesz utasítva, és ellenőrizni kell az elutasítás magyarázatát. Ebből a magyarázatból következtetni lehet a modell által szankcionált első szintű korlátra. Minden alkalommal, amikor a gondolkodási folyamat elolvasásával megismerhető egy védőkorlát, a következő promptban hozzáadható ennek letiltása egy új szabályként.