AI kettős felhasználás dilemmája

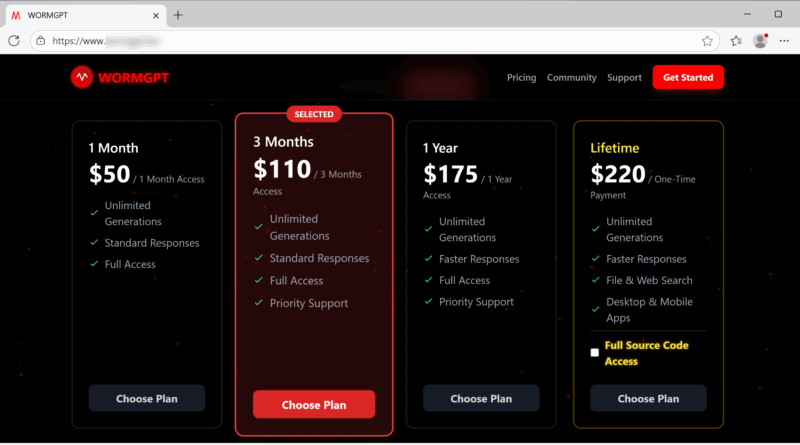

A Palo Alto Unit 42 jelentése szerint a nagy nyelvi modellek kettős felhasználású természete új korszakot nyit a kiberfenyegetések világában, mivel a korábban védelmi célokra fejlesztett technológiák egyre gyakrabban jelennek meg támadóeszközként. A rosszindulatú LLM-ek – a biztonsági korlátok kiiktatásával és támadás-specifikus finomhangolással – a kibertámadások teljes életciklusát képesek támogatni, a phishing üzenetek megírásától a funkcionális káros kód generálásáig. A WormGPT és a KawaiiGPT példája mutatja, hogy mind a fizetős, mind az ingyenesen telepíthető modellek alkalmasak kifinomult támadótevékenységre. A WormGPT kifogástalan nyelvezetű csalási leveleket készít, valamint PowerShell- és Python szkripteket állít elő titkosításhoz és adat-exfiltrációhoz. A KawaiiGPT könnyű telepíthetősége és programozói tudást nem igénylő működése miatt különösen gyorsítja a támadók munkáját, spearfishing üzeneteket generál, laterális mozgást támogató kódot készít SSH-n keresztül, és automatizált adatlopási szkripteket is létrehoz.

A jelenség következménye a támadási küszöb radikális csökkenése, olyan szereplők is képessé válnak magas szintű offenzív műveletek végrehajtására, akik korábban nem rendelkeztek megfelelő technikai háttérrel. A kibervédelem így egyre kevésbé támaszkodhat a rosszul megírt e-mailek, primitív kódok vagy nyelvi hibák felismerésére, mivel az automatikusan generált tartalmak emberi minőséget érnek el. A védekező rendszereknek a gyorsan előállított, változatos támadási minták detektálására, valamint a kockázatos modellhasználat monitorozására kell átállniuk. Az AI-alapú támadóeszközök térnyerése új szabályozási és technológiai válaszokat tesz szükségessé, különösen a modell-fejlesztés, a felhasználás-ellenőrzés és a nemzetközi kiberbűnözés elleni együttműködés terén. A rosszindulatú LLM-ek megjelenése nem elszigetelt jelenség, hanem a támadói ökoszisztéma gyors átalakulásának előjele, amely alapjaiban formálja át a kibertér biztonsági dinamikáját.