Reverse engineering AI-val gyorsítva

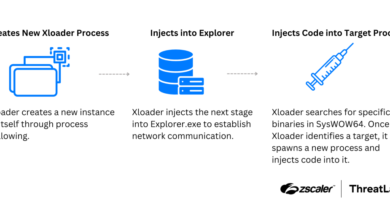

A Check Point Research azt vizsgálja, hogyan gyorsítja fel a generatív mesterséges intelligencia a bonyolult rosszindulatú kódok — például az XLoader 8.0 — fordított elemzését, és miként változtatja meg a reverse engineering munkafolyamatait. A tanulmány ismerteti, hogy az XLoader több egymásba ágyazott titkosítást és erős sandbox-elkerülést alkalmaz, ezért a hagyományos dinamikus elemzések gyakran csődöt mondanak, a kutatók azt mutatják be, hogy a nagymodelles LLM-ekkel (ChatGPT/GPT-5) végzett statikus elemzés és az MCP-alapú élő integráció kombinációja radikálisan lerövidíti az időt a dekódoláshoz és az IoC-k előállításához.

A szerző két, egymást kiegészítő munkafolyamatot ír le, az egyik az MCP-tel (Model Context Protocol) valós idejű, agentikus integráció, amely lehetővé teszi, hogy a modell közvetlenül lekérdezze az IDA Pro-t, beszúrjon breakpointekat, kiolvasson memóriatartalmakat és iteratív módon validálja a hipotéziseket egy debuggerrel; a másik az úgynevezett offline pipeline, amelyben az IDA adatait exportálják JSON-szerkezetben, feltöltik a ChatGPT projektbe, és promptokkal irányítva a modellt automatizáltan generált Python-szkripteket és elemzési jegyzeteket készíttetnek. A Check Point azt bizonyítja, hogy az offline módszer reprodukálható, megosztható és hatékony — különösen, ha nincs lehetőség vagy kényelmes fenntartani egy folyamatos, lokális IDA/MCP munkamenetet.

A gyakorlatban ez azt jelenti, hogy a korábban napokat vagy heteket igénylő feladatok — funkciók azonosítása, titkosítási algoritmusok feltárása, kulcsok és C2-címek kinyerése — órák alá süllyedhetnek. A cikk valós promptpéldákat és egy exportált IDA-archívum struktúráját is közli, továbbá beméri a különböző lépésekhez töltött időt, mutatva a generatív AI force multiplier jellegét, a modell képes javaslatokkal ellátni neveket, kommenteket, és működő kódot generálni, amelyet az elemző importálhat és validálhat.

Az MCP-alapú élő integráció hátránya a folyamatos helyi eszközigény és a hálózati függőség, míg a felhő-LLM-be feltöltött bináris és dekompilált adatok kezelése adatvédelmi, titoktartási és jogi aggályokat vet fel — különösen ha a minta érzékeny ügyféladatokat vagy zsarolóvírus-mintákat tartalmaz. A cikk ezért javasolja a projekt-alapú file-upload használatát (nem egyszeri chatbe történő beadást), a feltöltött fájlok és promptok előzetes átlátható dokumentálását, valamint az AI-eredmények emberi validálását és forrásokkal való keresztellenőrzését.

A gyakorlati tanulságok között szerepel továbbá, hogy az AI-segédlettel végzett reverz-munka nem helyettesíti a szakértői ítélőképességet, a modell hajlamos lehet hallucinálni, vagy pontatlan magyarázatot adni, ezért a kinyert kulcsokat, dekódolt stringszeket és C2-listákat mindig futtatható tesztekkel és debugger-ellenőrzéssel kell igazolni. A szerző részletes workflow-példákat ajánl, először export, majd struktúrált promptalapú feltárás, automata szkriptgenerálás, scriptfuttatás és végül élő debug validáció MCP-vel — e lépések kombinációja adja a legjobb kompromisszumot gyorsaság és megbízhatóság között.