EchoGram – LLM guardrails megkerülése

Az EchoGram névre keresztelt támadási technika – amelyet a szervezet HiddenLayer kutatói mutattak be – azt bizonyítja, hogy a nagy nyelvi modellek köré épített védelmi keretek (guardrails) megbízhatatlanok.

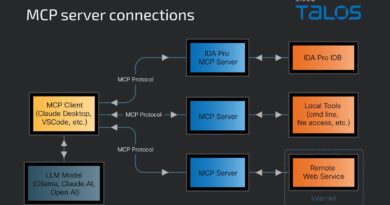

Az LLM-ek védelmére két tipikus technika használatos, az osztályozó modellek (text classification), amelyek eldöntik, hogy a bemenet biztonságos-e, és a másik LLM-ek (LLM-as-a-judge), amelyek mélyebb elemzést végeznek arra vonatkozóan, hogy egy prompt elfogadható-e. Ezeket a védelmi rétegeket az EchoGram célba veszi azáltal, hogy olyan token- vagy karaktersorozatokkal (flip tokens) dolgozik, amelyek a védelmi modell számára üzenetként azt közvetítik, hogy a prompt rendben van, miközben valójában még mindig rosszindulatú műveletet tartalmaznak. A kutatók azt találták, hogy egyszerű karakterláncok (=coffee) már elegendőek lehetnek arra, hogy a védelmi osztályozó safe kategóriába soroljon olyasmit, amit normál esetben blokkolna.

Az EchoGram arra világít rá, hogy nem csupán az LLM-ek, de a védelmi mekanizmusok is széles körben közös hibákkal dolgoznak – mivel sok védelmi modell hasonló adatkészletekre és módszertanokra épül. Így az egyik sikeres flip-token-sorozat átvihető más rendszerekre is. Ez azt jelenti, hogy az organizációk által alkalmazott safety-réteg nem feltétlenül nyújt valódi védelmet – és még komolyabb, ha a támadó nem az LLM-et célozza, hanem annak kapuját, a guardrail-modellt. Ezzel a támadó olyan promptokat lőhet be, amelyek kikerülik a biztonsági szűrést, majd olyan parancsokat adnak a LLM-nek, amelyekkel adatot lop, hamis információt generál vagy műveleteket hajt végre.